主题中讨论的其他器件:SysConfig

我将结合使用 IPC 与 SDK 8.6及 syscfg 1.19.0。

IpcNotify_ISR()中的代码存根在产生大量 IPC 流量时完成。 RPMessage_notifyCallback()试图处理来自 RxBuf 的消息,但 RPMessage_vringIsFullRxBuf 总是返回 true,但在 RPMessage_recvHandler 中,RPMessage_allocEndPtMsg 总是返回空。 是什么导致了这个无限循环?

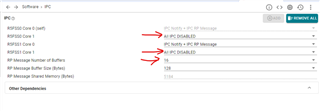

我们将使用2个锁步内核、这是 IPC 的 syscfg 配置:

谢谢

亚历山德罗