工具与软件:

我开发了一个不使用图像作为输入的序列模型。

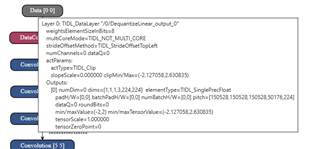

因此、网络输入采用浮点格式。

但是、TI 的默认深度学习架构是专为基于图像的模型设计的。

要在此环境中将浮点值输入到模型中、我使用了以下方法:

我检查了输入值范围并将其归一化、以适应0至255的范围。

例如、如果输入浮点值的范围是0到1、我会将std转换设置中的设置为1/255。

然后、在 C 代码中、我在将输入浮点值馈入网络之前将其乘以255。

这可以正常工作、因为std的1/255应用于配置cfg()中。

但是、8位表示法不符合浮点输入的范围要求、因为使用可表达式的最大值1/255是有限的。

如果有什么办法、请告诉我。