主题:AM62A7 中讨论的其他器件

工具/软件:

TI 开发大家好、

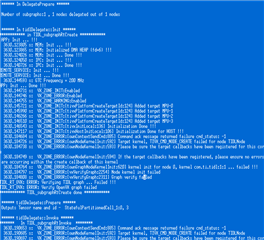

这是一个基本的自定义模型,我在 tesorfollow/keras 上构建,并将其转换为 tflite 文件。 该模型为非图像模型。

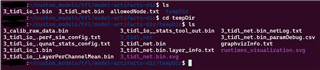

我将 tflite 文件复制到/model/public.内的 edgeai_tidl_tool 目录 我已经在 github.com/.../model_configs.py 中提供了模型配置 、但我不确定是否提供了正确的模型配置。 模型配置如下所示。

e2e.ti.com/.../Test_5F00_tflite.zip

此致、

密钥