工具/软件:

大家好、我有疑问。 编译模型时使用该工具 edgeai-tidl-tools 版本 11_00_06_00 和 settensor_bits = 8 ,编译的模型工作正常(虽然精度太低)。 但当我更改tensor_bits = 16后,编译后的模型将完全不可用。

我也尝试在中添加一些图层output_feature_16bit_names_list、但只要我在其中添加任何内容、编译后的模型就根本不能使用。 你知道为什么会发生这种情况吗?

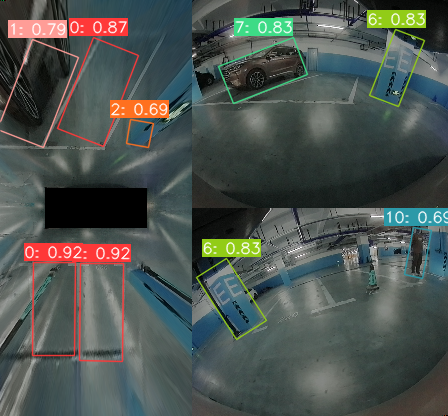

Tensor_bits = 8:

Tensor_bits = 16: