主题中讨论的其他器件:TDA2、 66AK2H12、

尊敬的 TI 专家:

我们有一些 ADAS 客户询问 TDA2系列 SoC 的计算能力。 我找不到一份官方文档、其中列出了 TI 以 GFLOPS/ TFLOPS 为单位的 TDA2x 计算能力、我们在哪里可以找到或如何计算该数字?

相比之下、ADAS 应用需要使用深度学习算法、 我们可以了解到、移动眼显示 EyeQ3提供~300GFLOPS、而 EyeQ4将该数字推至2.5TFLOPS。

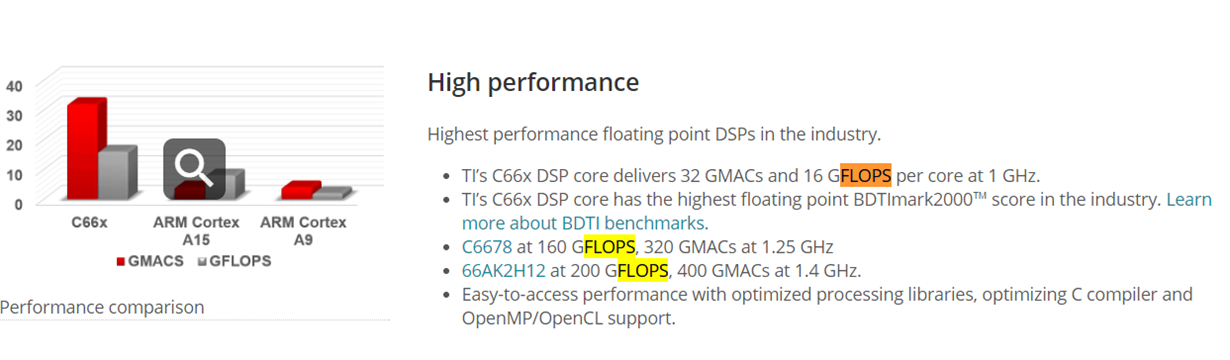

在 TI DSP 概览页面 http://www.ti.com/processors/dsp/overview.html上、我可以找到这些信息、即 TI C66x DSP 内核在1GHz 频率下可提供每内核32 GMAC 和16 GFLOPS 的性能。

我发现 ARM Cortex-A15的效率大约为6.9FLOPS/GHz/内核 (https://devtalk.nvidia.com/default/topic/813318/jetson-tk1/flops-for-jetson-host/ ),

因此、我计算了66AK2H12 (4* ARM Cortex-A15@1.4GHz,8* C66x @1.2GHz)的总计算功率应约为4*1.4GHz * 6.9GFLOPS/GHz + 8*1.2GHz * 16GFLOPS/GHz = 38GFLOPS + 153.6LOPS = 191.6 GFLOPS、这非常接近 TI DSP 概述页面上的200GFLOPS。

同样,我们可以计算 TDA2SX 的 GFLOPS (2 * arm Cortex-A15@1.176GHz,2 * C66x @0.75GHz),它是 2 * 1.176 GHz 6.9 GFLOPS/GHz + 2 0.75 GHz*16 GFLOPS/GHz = 16+24 =40 GFLOPS

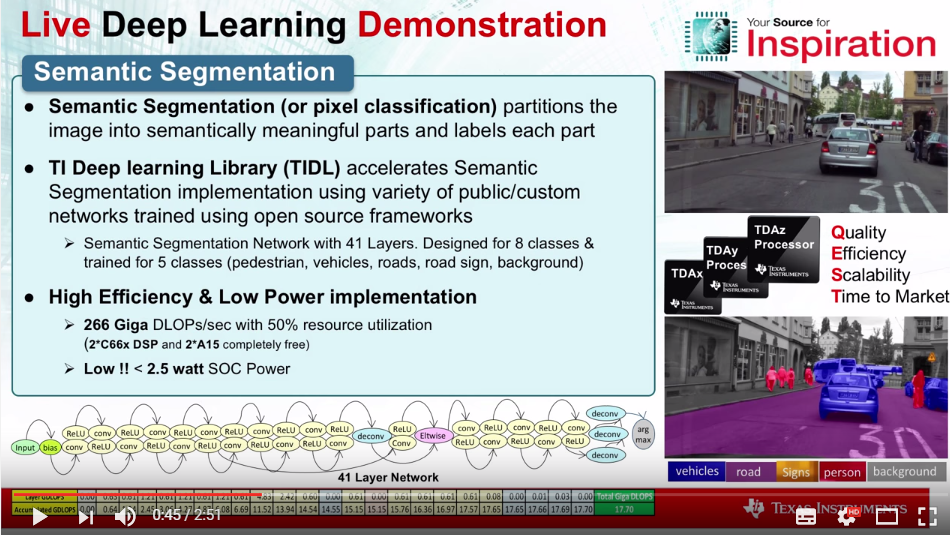

同时、我还从 YouTube (www.youtube.com/watch )上找到了一段视频、其中说 TDA2的计算能力为266千兆 DLOP

2.您能解释一下 DLOPs (我猜是“深度学习操作”)的含义吗? 它与 FLOPS 有什么关系?

由于 EyeQx 使用 MIPS CPU、而 MIPS CPU 的效率与 ARM Cortex-A CPU 相当、因此我怀疑3W SoC 将提供300GFLOPS 甚至2.5TFLOPS、而 TI TDA2x 只提供40GFLOPs……

那么、在深度学习领域、人们对浮点运算的定义是不同的吗? 我发现人们在深度学习算法中讨论过、只需要半精度浮点运算、但当人们经常谈论浮点时、它们意味着单精度浮点(请参阅 https://teslamotorsclub.com/tmc/threads/ap2-0-cameras-capabilities-and-limitations.86430/page-20 #396)。