工具/软件:Linux

尊敬的专家:

通过 AM3352上的以太网端口传输数据时出现封装丢失问题:

基本方框图为吹扫:

描述:

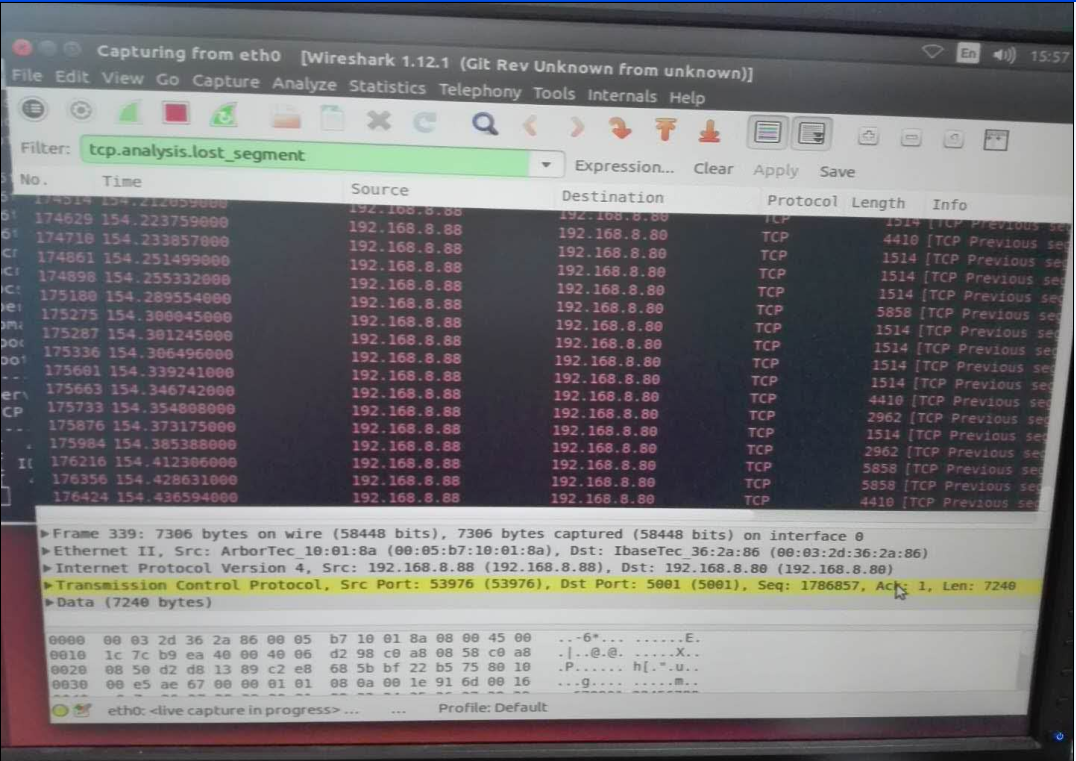

PC1充当客户端、PC2充当服务器、 AM3352重新配置为桥接模式、分别在2台 PC 上使用"iperf -s "和"iperf -c "传输数据并使用 Wireshark 监视数据包、 并在传输过程中观察到大量数据丢失。

测试条件:

TI-processor-SDK-Linux-AM335x-EVM-03.02.00.05

2. AM3352重新配置为桥接模式

3. CPSW 内核配置

AM335x-EVM.dts

5. am33xx.dtsi 配置:

您能给我一些关于如何消除数据丢失问题的指导吗、非常感谢。