主题中讨论的其他器件:AM6442

工具与软件:

您好、TI:

我使用的是最新的 TI SDK 版本:

https://www.ti.com/tool/download/PROCESSOR-SDK-LINUX-RT AM64X-AM64X

=> 09.02.01.10 (2024年5月30日)

在进行性能测试以减轻 HSR 解决方案负载的情况下、在3个 EVM 板之间进行转发时、我遇到了一些问题...

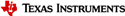

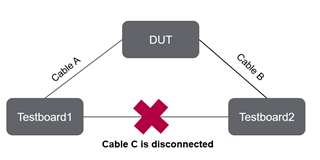

下面是我们的设置:

映像上没有电缆 C、因此从测试板1向2发送数据包时、它只通过应转发数据包的 DUT。

首先、我们在3个板上启用卸载解决方案、然后

我们将创建一个

- iperf3 (第3版)服务器在 Testboard2.

-在 Testboard1上启动 iperf3客户端

我们在测试板2侧观察到、很多数据包丢失了近50%

在日志中、我们可能发现电路板无法达到目标比特率、但是我们没有预计到丢失如此多的数据包。

我们还有一个测试,只接收数据包,以相同的速度,没有丢失的数据包...因此,我认为它可能来自转发部分

下面是 Testboard1的日志:

root@am64xx-evm:~# iperf3 -c 192.168.200.2 -t 40 -b 20M -l 400 -u Connecting to host 192.168.200.2, port 5201 [ 1079.537770] icssg-prueth icssg1-eth eth1: hsr_addr_subst_dest: Unknown node [ 5] local 192.168.200.1 port 52738 connected to 192.168.200.2 port 5201 [ ID] Interval Transfer Bitrate Total Datagrams [ 5] 0.00-1.00 sec 2.38 MBytes 20.0 Mbits/sec 6246 [ 5] 1.00-2.00 sec 2.38 MBytes 20.0 Mbits/sec 6250 [ 5] 2.00-3.00 sec 2.38 MBytes 20.0 Mbits/sec 6250 [ 5] 3.00-4.00 sec 2.38 MBytes 20.0 Mbits/sec 6250 [ 5] 4.00-5.00 sec 2.38 MBytes 20.0 Mbits/sec 6250 [ 5] 5.00-6.00 sec 2.38 MBytes 20.0 Mbits/sec 6250 [ 5] 6.00-7.00 sec 2.38 MBytes 20.0 Mbits/sec 6249 [ 5] 7.00-8.00 sec 2.38 MBytes 20.0 Mbits/sec 6251 [ 5] 8.00-9.00 sec 2.38 MBytes 20.0 Mbits/sec 6250 [ 5] 9.00-10.00 sec 2.38 MBytes 20.0 Mbits/sec 6250 [ 5] 10.00-11.00 sec 2.38 MBytes 20.0 Mbits/sec 6250 [ 5] 11.00-12.00 sec 2.38 MBytes 20.0 Mbits/sec 6250 [ 5] 12.00-13.00 sec 2.38 MBytes 20.0 Mbits/sec 6250 ^C[ 5] 13.00-13.29 sec 698 KBytes 20.0 Mbits/sec 1787 - - - - - - - - - - - - - - - - - - - - - - - - - [ ID] Interval Transfer Bitrate Jitter Lost/Total Datagrams [ 5] 0.00-13.29 sec 31.7 MBytes 20.0 Mbits/sec 0.000 ms 0/83033 (0%) sender [ 5] 0.00-13.29 sec 0.00 Bytes 0.00 bits/sec 0.000 ms 0/0 (0%) receiver iperf3: interrupt - the client has terminated root@am64xx-evm:~# dmesg | grep -i dual [ 7.704157] icssg-prueth icssg1-eth: TI PRU ethernet driver initialized: dual EMAC mode root@am64xx-evm:~# dmesg | grep -i hsr [ 94.632711] icssg-prueth icssg1-eth: Enabling HSR offload mode [ 97.864894] remoteproc remoteproc13: Booting fw image ti-pruss/am65x-sr2-pru0-pruhsr-fw.elf, size6 [ 97.867859] remoteproc remoteproc14: Booting fw image ti-pruss/am65x-sr2-rtu0-pruhsr-fw.elf, size2 [ 97.874690] remoteproc remoteproc7: Booting fw image ti-pruss/am65x-sr2-txpru0-pruhsr-fw.elf, siz8 [ 97.876706] remoteproc remoteproc15: Booting fw image ti-pruss/am65x-sr2-pru1-pruhsr-fw.elf, size8 [ 97.879813] remoteproc remoteproc16: Booting fw image ti-pruss/am65x-sr2-rtu1-pruhsr-fw.elf, size4 [ 97.885165] remoteproc remoteproc8: Booting fw image ti-pruss/am65x-sr2-txpru1-pruhsr-fw.elf, siz6 [ 103.222796] IPv6: ADDRCONF(NETDEV_CHANGE): hsr0: link becomes ready [ 519.446117] icssg-prueth icssg1-eth eth1: hsr_addr_subst_dest: Unknown node [ 1079.537770] icssg-prueth icssg1-eth eth1: hsr_addr_subst_dest: Unknown node root@am64xx-evm:~#

测试板3:

root@am64xx-evm:~# iperf3 -s -B 192.168.200.2 ----------------------------------------------------------- Server listening on 5201 (test #1) ----------------------------------------------------------- Accepted connection from 192.168.200.1, port 37026 [ 5] local 192.168.200.2 port 5201 connected to 192.168.200.1 port 52738 [ ID] Interval Transfer Bitrate Jitter Lost/Total Datagrams [ 5] 0.00-1.00 sec 1.18 MBytes 9.93 Mbits/sec 0.006 ms 3087/6191 (50%) [ 5] 1.00-2.00 sec 1.21 MBytes 10.1 Mbits/sec 0.006 ms 3084/6249 (49%) [ 5] 2.00-3.00 sec 1.20 MBytes 10.1 Mbits/sec 0.010 ms 3095/6250 (50%) [ 5] 3.00-4.00 sec 1.21 MBytes 10.2 Mbits/sec 0.006 ms 3066/6250 (49%) [ 5] 4.00-5.00 sec 1.19 MBytes 10.0 Mbits/sec 0.007 ms 3117/6244 (50%) [ 5] 5.00-6.00 sec 1.21 MBytes 10.1 Mbits/sec 0.007 ms 3094/6256 (49%) [ 5] 6.00-7.00 sec 1.20 MBytes 10.0 Mbits/sec 0.006 ms 3117/6251 (50%) [ 5] 7.00-8.00 sec 1.21 MBytes 10.2 Mbits/sec 0.009 ms 3065/6250 (49%) [ 5] 8.00-9.00 sec 1.23 MBytes 10.3 Mbits/sec 0.039 ms 3023/6250 (48%) [ 5] 9.00-10.00 sec 1.21 MBytes 10.2 Mbits/sec 0.005 ms 3073/6250 (49%) [ 5] 10.00-11.00 sec 1.21 MBytes 10.1 Mbits/sec 0.012 ms 3090/6251 (49%) [ 5] 11.00-12.00 sec 1.18 MBytes 9.91 Mbits/sec 0.004 ms 3155/6250 (50%) [ 5] 12.00-13.00 sec 1.20 MBytes 10.1 Mbits/sec 0.041 ms 3097/6249 (50%) [ 5] 12.00-13.00 sec 1.20 MBytes 10.1 Mbits/sec 0.041 ms 3097/6249 (50%) - - - - - - - - - - - - - - - - - - - - - - - - - [ ID] Interval Transfer Bitrate Jitter Lost/Total Datagrams [ 5] 0.00-13.00 sec 16.0 MBytes 10.3 Mbits/sec 0.005 ms 41078/83032 (49%) receiver iperf3: the client has terminated ----------------------------------------------------------- Server listening on 5201 (test #2) ----------------------------------------------------------- ^Ciperf3: interrupt - the server has terminated root@am64xx-evm:~# dmesg | grep -i hsr [ 247.158219] icssg-prueth icssg1-eth: Enabling HSR offload mode [ 250.374314] remoteproc remoteproc13: Booting fw image ti-pruss/am65x-sr2-pru0-pruhsr-fw.elf, siz6 [ 250.375972] remoteproc remoteproc14: Booting fw image ti-pruss/am65x-sr2-rtu0-pruhsr-fw.elf, siz2 [ 250.384031] remoteproc remoteproc7: Booting fw image ti-pruss/am65x-sr2-txpru0-pruhsr-fw.elf, si8 [ 250.386566] remoteproc remoteproc15: Booting fw image ti-pruss/am65x-sr2-pru1-pruhsr-fw.elf, siz8 [ 250.388136] remoteproc remoteproc16: Booting fw image ti-pruss/am65x-sr2-rtu1-pruhsr-fw.elf, siz4 [ 250.396842] remoteproc remoteproc8: Booting fw image ti-pruss/am65x-sr2-txpru1-pruhsr-fw.elf, si6 [ 255.708977] IPv6: ADDRCONF(NETDEV_CHANGE): hsr0: link becomes ready [ 305.665283] icssg-prueth icssg1-eth eth1: hsr_addr_subst_dest: Unknown node [ 1441.355059] icssg-prueth icssg1-eth eth1: hsr_addr_subst_dest: Unknown node [ 1550.216740] icssg-prueth icssg1-eth eth1: hsr_addr_subst_dest: Unknown node [ 1930.843411] icssg-prueth icssg1-eth eth1: hsr_addr_subst_dest: Unknown node [ 3089.635475] icssg-prueth icssg1-eth eth1: hsr_addr_subst_dest: Unknown node [ 5026.009308] Modules linked in: pci_endpoint_test cdns3 cdns_usb_common irq_pruss_intc crct10dif_6 root@am64xx-evm:~# dmesg | grep -i dual [ 8.111898] icssg-prueth icssg1-eth: TI PRU ethernet driver initialized: dual EMAC mode

DUT:

root@am64xx-evm:~# dmesg | grep -i hsr [ 351.912864] icssg-prueth icssg1-eth: Enabling HSR offload mode [ 354.960940] remoteproc remoteproc13: Booting fw image ti-pruss/am65x-sr2-pru0-pruhsr-fw.elf, size 37976 [ 354.966242] remoteproc remoteproc14: Booting fw image ti-pruss/am65x-sr2-rtu0-pruhsr-fw.elf, size 34632 [ 354.969989] remoteproc remoteproc7: Booting fw image ti-pruss/am65x-sr2-txpru0-pruhsr-fw.elf, size 36128 [ 354.972367] remoteproc remoteproc15: Booting fw image ti-pruss/am65x-sr2-pru1-pruhsr-fw.elf, size 38208 [ 354.973763] remoteproc remoteproc16: Booting fw image ti-pruss/am65x-sr2-rtu1-pruhsr-fw.elf, size 33844 [ 354.975396] remoteproc remoteproc8: Booting fw image ti-pruss/am65x-sr2-txpru1-pruhsr-fw.elf, size 34636 [ 360.067705] IPv6: ADDRCONF(NETDEV_CHANGE): hsr0: link becomes ready root@am64xx-evm:~# dmesg | grep -i dual [ 7.568566] icssg-prueth icssg1-eth: TI PRU ethernet driver initialized: dual EMAC mode root@am64xx-evm:~#

您是否可以重现此问题?

Tianyi Liu