工具与软件:

大家好、团队:

在 TIDL 10.00.08.00中

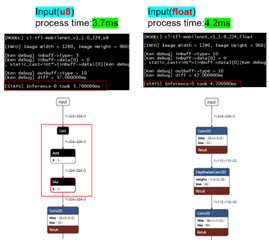

我尝试使用输入= uint8且输入= float 来转换默认模型(mobilenet1v)、

我发现 input=uint8的模型会执行去量化步进、

而其余器件与 input=float 的模型相同。

不过、input=uint8的模型实际上具有更短的推理时间。

我不知道为什么会出现这种症状。

感谢您的帮助。

此致、

Ken

This thread has been locked.

If you have a related question, please click the "Ask a related question" button in the top right corner. The newly created question will be automatically linked to this question.

工具与软件:

大家好、团队:

在 TIDL 10.00.08.00中

我尝试使用输入= uint8且输入= float 来转换默认模型(mobilenet1v)、

我发现 input=uint8的模型会执行去量化步进、

而其余器件与 input=float 的模型相同。

不过、input=uint8的模型实际上具有更短的推理时间。

我不知道为什么会出现这种症状。

感谢您的帮助。

此致、

Ken

大家好、 Chris Tsongas、 Christina Kuruvilla:

很抱歉因我的个人休假而延迟回复。

我错过了以下结果:

您好 Christina Kuruvilla:

很抱歉混淆,但我想问我的理解是否正确吗?

如果原始 ONNX 文件的输入为 u8、则在通过onnxrt_ep.py(使用tensor_bit=8)转换后、推理过程将以 int 运行。

但是,如果原始 ONNX 文件的输入为 float ,则在通过onnxrt_ep.py(使用tensor_bit=8)转换后,推理过程仍将以 float 方式运行。

感谢您的帮助。

此致、

肯尼亚

您好 Christina Kuruvilla:

很抱歉打扰您、但我想问:

如果输入是 u8、并在去量化后变为浮点型、那么中间的计算怎么仍然可以在 u8中执行?

感谢您的帮助。

此致、

Ken

大家好、 Chris Tsongas:

model_zoo/TFL-CL-0000-mobileNetV1-mlperf/model/mobilenet_v1_1.0_224.tflite 中的 tflite 模型是:

输入(u8)-->去量化(u8到 float)-->转换(float)

这就是我感到困惑的原因。

可能的模型工作流程包括:

这些工作流中的哪一个可用于生成 U8模型 通过onnxrt_ep.py?

此外、我要确认: tensor_bitsmodel_configs.py是否已在中设置?

例如、采用以下格式:

optional_options=AttrDict(

debug_level=6,

tensor_bits=8

)

Thanks for your kindly help.

Best Regards,

Ken尊敬的 Ken:

所有 TIDL 都是8位或16位 int。 该器件上没有浮点支持。 流程如下:

1.内部输入-> 8/16位流过网络-> 8/16位输出

2.浮动输入-> 8/16位通过网络的流量-> 8/16位输出

将 tensor_bits 设置为8。 如果数据是以 float 格式传输(而不是以照相机格式传输、即 int 格式传输)、则可能需要从 float 格式转换到 int 格式的输入转换层、具体取决于您的 TIDL 版本。

此致、

Chris