Part Number: SK-AM62A-LP

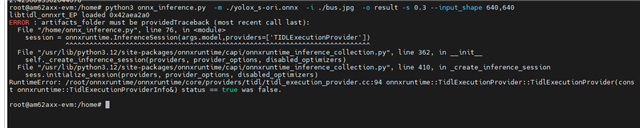

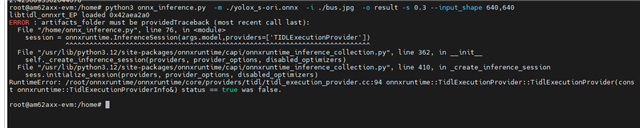

使用session = onnxruntime.InferenceSession(args.model,providers=['TIDLCompilationProvider'])

onnxruntime部分 session =onnxruntime.InferenceSession(args.model,providers=['TIDLExecutionProvider'])

还是说必须使用edge-ai重新训练一个模型以得到两个yaml文件

This thread has been locked.

If you have a related question, please click the "Ask a related question" button in the top right corner. The newly created question will be automatically linked to this question.

Part Number: SK-AM62A-LP

使用session = onnxruntime.InferenceSession(args.model,providers=['TIDLCompilationProvider'])

onnxruntime部分 session =onnxruntime.InferenceSession(args.model,providers=['TIDLExecutionProvider'])

还是说必须使用edge-ai重新训练一个模型以得到两个yaml文件

我参考的板端edgeai-dl-infer的py文件。但是没有看到readme之类的文档,想询问一下artifacts参数example

参考了model_zoo的内容artifacts能通过除了使用edgeai-lab训练的其他方法获得吗

参考了model_zoo的内容artifacts能通过其他方法获得吗

您好,

大多数TIDL文档是作为edgeai-tidl-tools库的一部分托管的;请参阅下面链接的custom-model-eval文档

edgeai-tidl-tools/docs/custom_model_evaluation.md at master · TexasInstruments/edgeai-tidl-tools · GitHub

建议查看此存储库中的顶级README文件 edgeai-tidl-tools/examples/osrt_python/README.md at master · TexasInstruments/edgeai-tidl-tools · GitHub

不建议从edgeai-dlinferer开始,因为这只能用于对目标运行推理,不适用于编译

编译需要在x86 PC上完成。

您好,我这边尝试了修改edgeai-tidl-tools/examples/orst_python/model_configs.py

models_configs = {

############ onnx models ##########

'yolov8n-ori' : {

'model_path' : os.path.join(models_base_path, 'yolov8n.onnx'),

'mean': [0, 0, 0],

'scale' : [0,0,0],

'num_images' : numImages,

'num_classes': 80,

'model_type': 'detection',

#'od_type' : 'YoloV',

'session_name' : 'onnxrt' ,

'framework' : ''

},

}

edgeai-tidl-tools/examples/orst_python/ort/onnxrt_ep.py的

models = [

#"cl-ort-resnet18-v1",

# "od-ort-ssd-lite_mobilenetv2_fpn"

'yolov8n-ori'

]

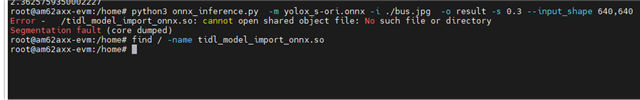

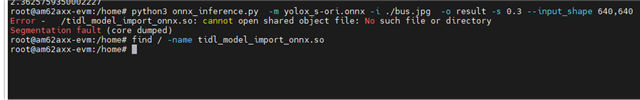

这里是报错

Command : python3 tflrt_delegate.py in Dir : examples/osrt_python/tfl Started

Running 0 Models - []

Command : python3 onnxrt_ep.py in Dir : examples/osrt_python/ort Started

Available execution providers : ['TIDLExecutionProvider', 'TIDLCompilationProvider', 'CPUExecutionProvider']

Running 1 Models - ['yolov8n-ori']

Process Process-1:

Traceback (most recent call last):

File "/home/zxb/.pyenv/versions/3.10.15/lib/python3.10/multiprocessing/process.py", line 314, in _bootstrap

self.run()

File "/home/zxb/.pyenv/versions/3.10.15/lib/python3.10/multiprocessing/process.py", line 108, in run

self._target(*self._args, **self._kwargs)

File "/home/zxb/Desktop/ti/edgeai-tidl-tools/examples/osrt_python/ort/onnxrt_ep.py", line 221, in run_model

download_model(models_configs, model)

File "/home/zxb/Desktop/ti/edgeai-tidl-tools/examples/osrt_python/common_utils.py", line 240, in download_model

model_path = models_configs[model_name]["session"]["model_path"]

KeyError: 'session'

Running_Model : yolov8n-ori

能麻烦ti那边给一些yolo的例子不

①[参考译文] TDA4VM:TDA4VM:TDA4VM 评估板中的 YOLOv8 ONNX 编译要求 - 处理器(参考译文帖)(Read Only) - 处理器(参考译文帖) - E2E 设计支持

[参考译文] TDA4VM:[e-mirror] SDK 8.5是否支持 yolov8? - 处理器(参考译文帖)(Read Only) - 处理器(参考译文帖) - E2E 设计支持

[参考译文] SK-TDA4VM:运行 YOLOV8 - 处理器(参考译文帖)(Read Only) - 处理器(参考译文帖) - E2E 设计支持

[参考译文] SK-TDA4VM:预培训 Yolo 转换 - 处理器(参考译文帖)(Read Only) - 处理器(参考译文帖) - E2E 设计支持

[参考译文] AM68A:YoloV8 TIDL 9.2 - 处理器(参考译文帖)(Read Only) - 处理器(参考译文帖) - E2E 设计支持 :

[参考译文] TDA4VM:使用 TIDL 模型导入来编译自定义模型 - 处理器(参考译文帖)(Read Only) - 处理器(参考译文帖) - E2E 设计支持:

据我所知,我们不支持 SDK 9.1上的 v8 end to end。

[参考译文] AM68A:am68a 上的 yolov8物体检测模型实现 - 处理器(参考译文帖)(Read Only) - 处理器(参考译文帖) - E2E 设计支持

[参考译文] TDA4VM:将不受支持的 OD 模型(yolov8)移植到 TDA4VM - 处理器(参考译文帖)(Read Only) - 处理器(参考译文帖) - E2E 设计支持:Unsolved problem

Q1:YOLOV8现在支持了吗

②[参考译文] TDA4VM:Edgeai-tidl-tools 未能编译 yolov8n-obb 模型 - 处理器(参考译文帖)(Read Only) - 处理器(参考译文帖) - E2E 设计支持:

Q2:我在model_configs.py里面添加od_type 报错SyntaxError: invalid syntax. Perhaps you forgot a comma?

③'yolov8n-ori' : create_model_config(

preprocess=AttrDict(

resize=640,

crop=640,

data_layout="NCHW",

resize_with_pad=False,

reverse_channels=False,

),

session=AttrDict(

session_name="onnxrt",

model_path= "/home/zxb/Desktop/ti/edgeai-tidl-tools/models/public/yolov8n.onnx",

model_type='od',

opset=12,

input_mean=[0, 0, 0],

input_scale=[0, 0, 0],

#od_type='YoloV5'

input_optimization=True,

),

task_type="detection",

extra_info=AttrDict(num_images=numImages, num_classes=80),

),

我解决了一些其他的问题,后面还是提示要prototxt

onnxruntime.capi.onnxruntime_pybind11_state.InvalidProtobuf: [ONNXRuntimeError] : 7 : INVALID_PROTOBUF : Load model from /home/zxb/Desktop/ti/edgeai-tidl-tools/models/public/yolov8n.onnx failed:Protobuf parsing failed.

我尝试使用了yolox export_onnx.py 的def export_prototxt 但是有很多的很问题。现在我又在mmdetection上面寻找解决方案,但是成效比较慢,希望能得到回复以加快项目进度