工具/软件:

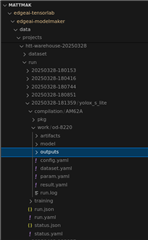

附加图像位于 Outputs 文件夹下。 我的问题是:

edgeai-tensorlab 或 edgeai-modelmaker 中的哪个 shell/python 脚本会生成此 outputs 文件夹? 我想知道输出下的图像是我的模型.onnx 文件的推理结果还是.pth 文件。

This thread has been locked.

If you have a related question, please click the "Ask a related question" button in the top right corner. The newly created question will be automatically linked to this question.

工具/软件:

附加图像位于 Outputs 文件夹下。 我的问题是:

edgeai-tensorlab 或 edgeai-modelmaker 中的哪个 shell/python 脚本会生成此 outputs 文件夹? 我想知道输出下的图像是我的模型.onnx 文件的推理结果还是.pth 文件。

尊敬的 YL:

我们很高兴回答您的问题。

edgeai-tensorlab 或 edgeai-modelmaker 中的哪个 shell/python 脚本会生成此输出文件夹? [/报价]此文件: https://github.com/TexasInstruments/edgeai-tensorlab/blob/main/edgeai-benchmark/edgeai_benchmark/postprocess/transforms.py#L525 包含 POST 过程(包括保存图像)的代码。 但是、这不会回答您下面的问题。

Unknown 说:我想知道输出下的图像是我的模型.onnx 文件还是.pth 文件的推理结果。输出下的图像是在主机上仿真的编译模型的推理结果。 因此、它们不是原始.onnx 模型的推理结果、而是生成的工件。

此致、

Qutaiba

[/quote]

感谢 Qutaiba、

我将相同的图像上传到 SK-AM62A-LP 并进行推理、我发现它们的性能不同。 在主机上仿真的已编译模型的推理结果明显优于 SK-AM62A-LP 产生的推理结果。

我的问题是:

根据我的理解、 如果性能不相同、则性能应该相似、因为两种场景都 在相同生成的工件上显示了推理结果。 唯一的区别应该是推理速度。

但现在在主机上(在我的例子中为 rtx3080)比 SK-AM62A-LP 上的后者更好。 为什么?

推理性能是否与硬件限制有关?

尊敬的 Quitaiba:

感谢您的快速答复。

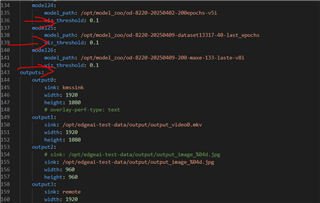

我已经比较了两个平台(主机 PC 和 SK-AM62A-LP)的检测阈值。 两个阈值都为0.1。 以下是证据。

上面的显示了主机 PC 中的 CONFIG.YAML。 后处理过程中的 detection_threshold 为0.1。

上面的显示了 object_detection.yaml. viz_threshold 为0.1。

有什么我错过了吗? 尽管设置和配置非常相似(如果不相同)、但我仍然不明白主机 PC 和 SK-AM62A-LP 中的推理结果为何不同。

尊敬的 YL:

我建议遵循本文档中提供的、针对您所观察到的内容的调试步骤: https://github.com/TexasInstruments/edgeai-tidl-tools/blob/master/docs/tidl_osr_debug.md#steps-to-debug-error-scenarios-for-targetevmdevice-execution

本文档是 tidl-tools 的一部分、在模型编译和调试方面比模型制作器更全面。

此致、

Qutaiba

尊敬的 Quitaiba:

那么、您是说、当涉及单独进行模型编译时、您建议使用 edgeai-tidl-tools 而不是 edgeai-benchmark?

此外、是否可以单独使用 edgeai-benchmark 编译模型、而无需经过 edgeai-modelmaker 流水线? 我问这个问题、因为 edgeai-modelmaker 包含模型训练、这可能非常耗时。

此致、

马特

尊敬的 Matt:

因此、当涉及单独进行模型编译时、您建议使用 edgeai-tidl-tools 而不是 edgeai-benchmark?

是的、对于模型编译、我建议使用 edgai-tidl-tools。 请参阅以下示例以启动: https://github.com/TexasInstruments/edgeai-tidl-tools/tree/master/examples/osrt_python

另外、是否可以单独使用 edgeai-benchmark 编译模型、而无需经过 edgeai-modelmaker 流水线? 我会问、因为 edgeai-modelmaker 包含模型训练、这可能非常耗时。

是的、您也可以使用 edgeai-benchmark 直接编译模型。

如果您需要重新训练模型、我建议使用 modelmaker。 请参阅此页面中的 BYOD 图: https://software-dl.ti.com/processor-sdk-linux/esd/AM62AX/latest/exports/edgeai-docs/common/inference_models.html#model-training-tools

对于仅编译、我建议使用 edgeai-tidl-tools。 请参阅本页中的 BYOM: https://software-dl.ti.com/processor-sdk-linux/esd/AM62AX/latest/exports/edgeai-docs/common/inference_models.html#import-custom-models

此致、

Qutaiba