主题中讨论的其他器件:TDA4VM

工具与软件:

大家好、我参考了 主 TexasInstruments/edgeai-tidl-tools··GitHub 上的 edgeai-tidl-tools/docs/custom_model_evaluation.md 和 edgeai-tidl-tools。edgeai-tidl-tools/examples/osrt_python/README.md 位于主 TexasInstruments/edgeai-tidl-tools··GitHub 上

在 x86 PC 中编译

我试图 在 edgeai-tidl-tools/examples/orst_python/model_configs.py 中添加新参数

models_configs ={

######################## ONNx 型号############

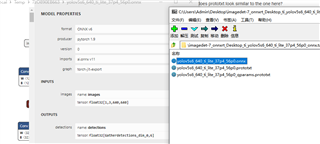

'yolov8n-ori':{

'model_path': os.path.join(models_base_path,'yolov8n.onnx'),

'MEAN':[0、0、0]、

'scale':[0、0、0]、

'num_images': numImages,

'NUM_CLASSES_':80、

"odel_type":"detection"、

#'od_type':'YoloV'、

'Session_name':'onnxrt',

"框架":""

}、

}

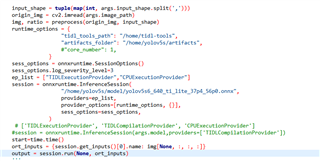

edgeai-tidl-tools/examples/orst_python/ort/onnxrt_ep.dl py的

模型=[

#"cl-ort-resnet18-v1"、

#"od-ort-ssd-lite_mobilenetv2_FPN"

'yolov8n-ori'

]

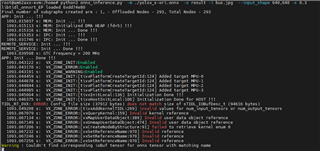

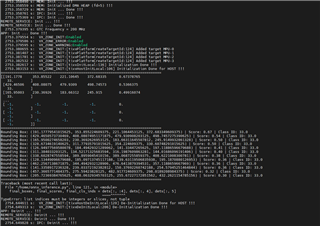

这是误差:

==============================================================================================

Command : python3 tflrt_delegate.py in Dir : examples/osrt_python/tFL started

运行0个模型-[]

命令: python3 onnxrt_ep.py in Dir : examples/osrt_python/ort started

可用的执行提供程序:['TIDLExecutionProvider ','TIDLComplationProvider ','CPUExecutionProvider ']

运行1个模型-['yolov8n-ori']

工艺流程1:

回溯(最近的呼叫最后):

文件"/home/zxb/.pyenv/versions/3.10.15/lib/python3.10/multiprocessing/process.py、第314行、位于_bootstrap 中

self.run()

文件/home/zxb/.pyenv/versions/3.10.15/lib/python3.10/multiprocessing/process.py、第108行、运行中

self._target(*self._args,**self._kwargs)

文件"run_model 中的第221行为/home/zxb/Desktop/ti/edgeai-tidl-tools/examples/osrt_python/ort/onnxrt_ep.py

download_model (models_configs、model)

download_model 中的文件"/home/zxb/Desktop/ti/edgeai-tidl-tools/examples/osrt_python/common_utils.py、第240行

model_path = models_configs[model_name]["session"]["model_path"]

键错误:'Session'(会话)

Running_Model : yolov8n-ori.

======================================================================================================================

我能不能 麻烦 ti 给出 yolov8的一些例子,谢谢

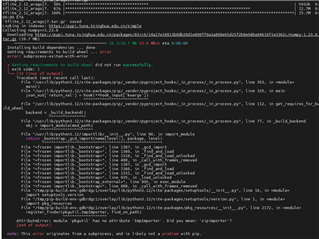

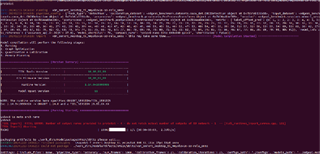

、但它不会生成 protoxt 文件。 有模块 NotFoundError 时:没有名为"edgeai_torchmodeloption"的模块、我将 edgeai-tensorlab-main\edgeai-modeloptimization\torchmodelopt 复制 到 mmyolo\projects\myeasydeploy\tools\importError export_onnx.py:无法导入名称"_parase_stack_trace\tor_trace\tor\packages\da\packages\motor\packages\motor\packages\motor\packages\motor\packages\motor\packages\motor\packages\__LW_AT__:。()。

、但它不会生成 protoxt 文件。 有模块 NotFoundError 时:没有名为"edgeai_torchmodeloption"的模块、我将 edgeai-tensorlab-main\edgeai-modeloptimization\torchmodelopt 复制 到 mmyolo\projects\myeasydeploy\tools\importError export_onnx.py:无法导入名称"_parase_stack_trace\tor_trace\tor\packages\da\packages\motor\packages\motor\packages\motor\packages\motor\packages\motor\packages\motor\packages\__LW_AT__:。()。