主题中讨论的其他器件:AM68A、AM69A 、AM67A

工具与软件:

问:

"我发现 TI 的 Model Zoo 拥有神经网络、这些神经网络已使用 C7x AI 加速器在 AM6xA 处理器[AM62A、AM67A、AM68A、AM68PA、AM69A 或 TDA4x SoC]上经过验证并具有基准测试。"

"我需要使用我收集的数据集为自己的应用训练这些模型。 该怎么做?"

答:

以上是开发者想要将 TI 的预优化网络用于其定制应用时遇到的相当常见的问题。 建议使用其中一些模型、因为它们已针对运行时延迟和精度进行了分析和优化。 TI 提供的模型已就通用数据集(例如 COCO 或 Imagenet1k)进行了预训练、但可能需要重新培训才能应用于自定义用例。

对于某些网络、我们对原始网络架构进行了修改、对 AM6xA 和 TDA4x SoC 上使用的硬件加速器 C7xMMA 更加友好。 这些修改通常是为了提高我们的定点加速器的精度或运行时效率。 例如、将 SiLU 激活函数替换为 Relu 在定点上要快得多。 我们通过在基准或模型 zoo 存储库中的模型名称中包含"lite"或"TI lite"来表示这些修改后的架构。

在最近的操作员支持下、某些原始模型可能会按原样得到支持、而以前并不支持这些原始模型。 请参阅我们的受支持运算符/层列表(以及任何相关限制)以了解最新信息、并请注意、该文档是关于我们 SDK 的版本指定。

在后续回复中、我将对 Model Zoo 中与再培训和重复使用相关的模型进行描述和分类。

注释的链接和存储库:

- edgeai-tensorlab

- 拥有多种用于模型训练、优化、编译和基准测试的编程工具

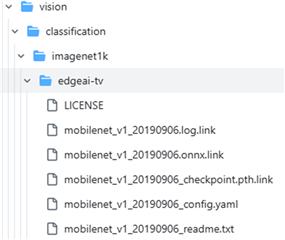

- edgeai-modelzoo

- tensorlab 的一部分、托管 modelzoo 的链接和文件、包括一些预先生成的模型工件。 这之前是一个单独的存储库(2024年7月之前)、因此如果您在 GitHub 上找到 edgeai-modelzoo 的存档版本、那么它很可能已过时。

- Edge AI Studio

- 基于 GUI 的在线工具、用于训练模型、查看预先生成的基准测试和其他 AI 模型开发任务。

- 请参阅模型选择工具以了解预生成的基准测试

- edgeai-tidl-tools

- 用于编译已导出为 ONNX 或 TFLITE 格式的已训练模型的独立工具

请注意、为了您的利益、我在文本中嵌入了大量链接。 这些链接中的大多数链接都可以访问 edgeai-tensorlab 或 edgeai-tidl-tools 存储库。

TL;DR (过长、未读取):TI 有一组 AI 模型已在我们的 SOC 上进行验证和基准测试。 这些器件可以重新训练、但并非所有架构都有 TI 提供的完整示例和编程工具供您自己进行再培训。 在本常见问题解答中、我将介绍负责设计此流程的可用资源和必要知识。 一些架构经过修改并标记为"TI Lite"、以表示架构与原始版本不同。 其他引脚由 TI 按原样制定。 TI-Lite 模型需要一些 TI 硬执行以便在训练过程中类似地进行的优化;未修改的架构对训练的 TI 支持有限(但 使用 TIDL 工具编译时支持 e2e)